入手攝影機時,不免也會在意一下該設備是否具備「4K感光元件」,然而,標榜著4K解析度的感光元件,真的每個像素都能發揮到極致嗎?

過去我們在乎的是:影像在由傳感器輸出至編碼器時如何取樣、壓縮,較少去關心編碼前、感光元件自身的處理,國外CookeOpticsTV頻道採訪了電影攝影師傑夫·波伊爾(Geoff Boyle),他解釋了為什麼「4K攝影機也不算是真正的4K」,並對於現今各家攝影機不斷在解析度上較勁,表示不以為然。

感光元件的彩度與明度傳導方式

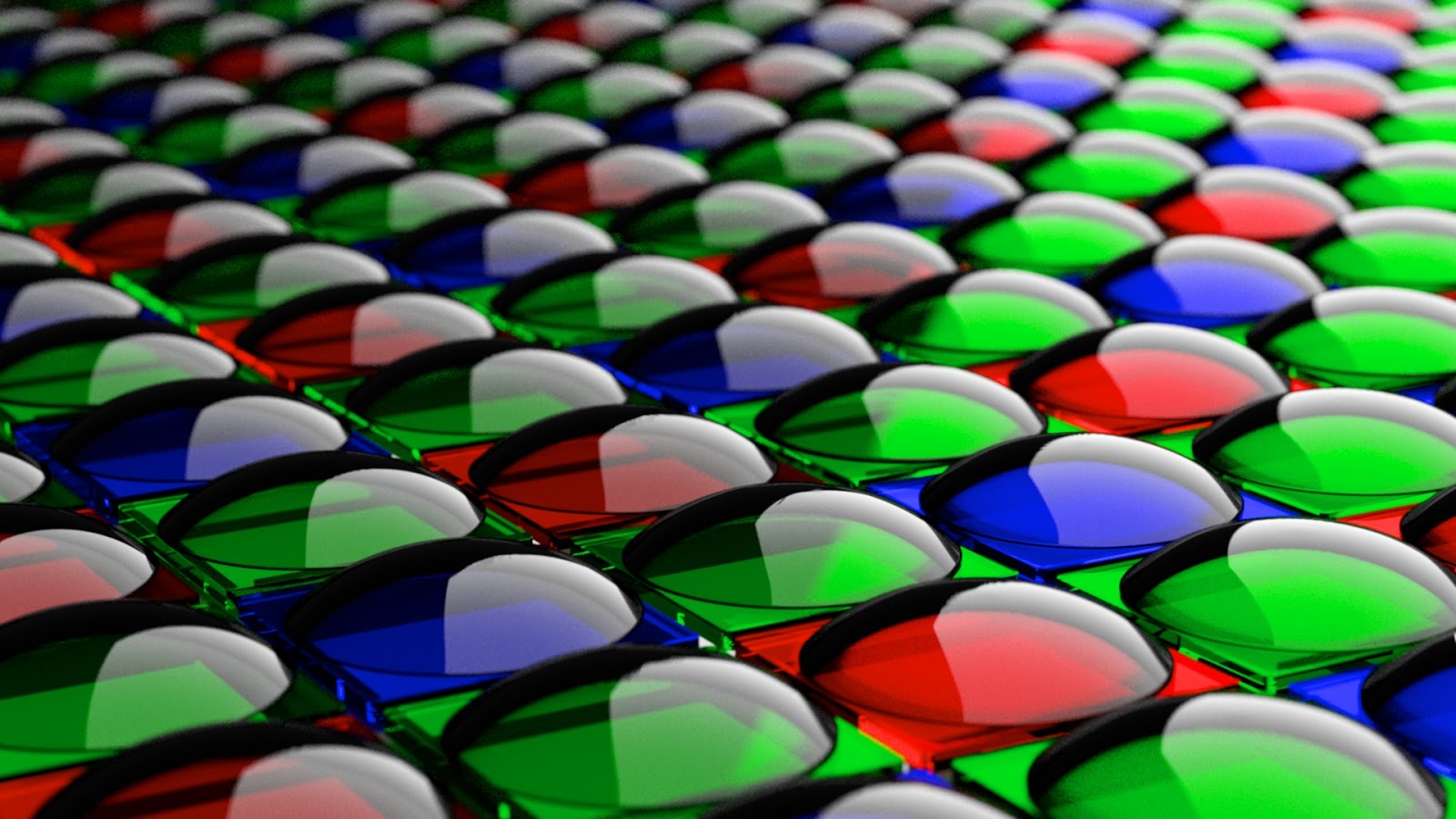

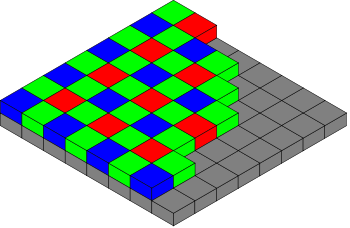

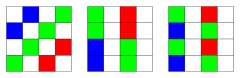

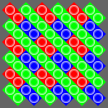

大部份攝影機的感光元件皆以拜爾濾色鏡(Bayer Filter)來傳導色彩光線,常見是針對RGB(紅綠藍)三個顏色紀錄。人眼對於綠光最為敏感,所以綠色光傳感器稱作光敏偵測元件,紅、藍色則稱為色敏偵測元件,這些元件我們稱之為「濾色器」,可理解為感光元件自身的像素。所以濾色器排列時,50%是綠色,25%是紅色,25%是藍色。每一濾色器一次只能紀錄其中一種顏色的資訊。

在每一個濾色器中,只有自身顏色(綠或紅、藍)的光能傳入,該像素就會紀錄該顏色的”值”。

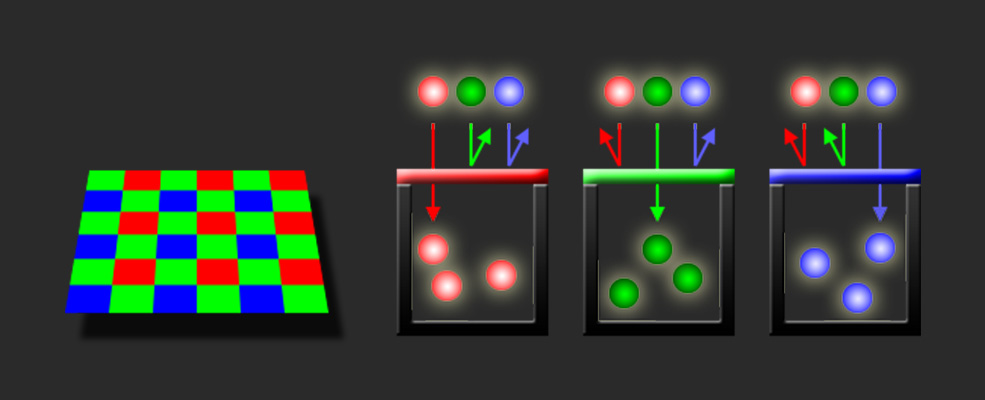

去拜爾(Debayering)

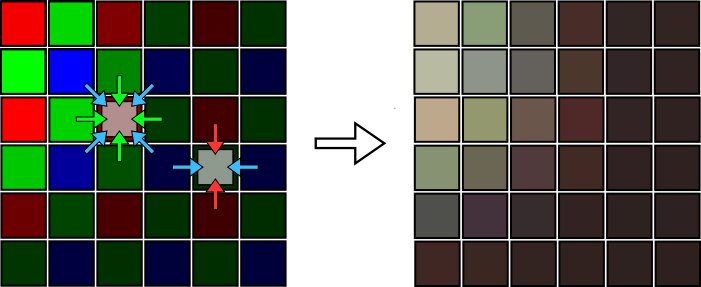

去拜爾又可稱為去馬賽克(Demosaicing),下圖為放大4倍後的影像,左圖為感光元件所紀錄的拜爾數據,右圖則是去拜爾之後的影像,可以理解成感光元件自身的”解碼”。

那去拜爾是如何做到的? 濾色器,也就是每格像素的明度都是以G(綠)為取樣,如果在R(紅)或B(藍)的像素中,便會取用周圍的G值來推算自己的「明度」; 而「彩度」,如果這一格是R,則也會用周圍的G和B加上自己的R值,演算出自身的RGB彩度,進而還原我們人眼所看到的影像。

感光元件內部的這些去拜爾程序完成後,便將數據送至攝影機的編碼器,而編碼器如何儲存或輸出,就是另一回事了。

以上解釋簡易的去拜爾概念,實際上感光元件內部的去拜爾程序可能更複雜,不同廠家的攝影機型都不一樣,除了拜爾的演算法不同,感光元件材料、構造也不盡相同,所以才會讓不同品牌在拍攝時,發生了SONY看似偏綠、Canon的皮膚偏紅…等現象。

如果是錄製RAW格式的影片,拜爾數據會以metadata的方式完整保存,不過在電腦上播放時,會因不同的軟體的解碼而產生不同的色彩結果。

編碼前,畫素早已低於期望!?

也許你會感到錯愕,原來在感光元件中,單個像素竟不包含RGB與明暗的完整資訊,而是左鄰右舍作弊互抄的,讀到這裡突然有心碎的感覺…。

其實自有數位傳感器以來,都是如此,說是廠商偷吃步嘛,也早以從上世紀就開始,但我們從來沒太去在意感光元件的構造,只在意後續編碼器的色彩取樣(如4:2:2、4:2:0)或色彩的位元深度(如8bit、10bit),正是這一點讓Geoff對於標榜高畫素的設備競賽,只能以翻白眼回應。

依照Geoff的說法:將感光元件所聲稱的畫素乘以0.7才是感光元件真正提供的像素水準,例如Alexa的2.8K素材,乘以0.7=1.96K,所以就實際的畫素來說,Alexa的2.8K素材應用在FullHD的專案上,效果才會是最好。依此類推,攝影機需具備6K的拍攝能力,才能在4K的專案中真正發揮到最佳效果。

結論

「一昧的要求要4K感光元件的攝影機,但其實你只達到了FullHD的品質,不如好好回來想一想,真的需要這麼在意高畫素嗎?」Geoff個人認為:「在片場甚至有些攝影師為了不要太過銳利的細節,還刻意加裝Diffusion(柔化)濾鏡,相較於畫素,動態範圍反倒更值得重視。」

此番言論一出,在國外論壇上也引起激烈的討論,有些攝影師認為Geoff過於貶低了畫素的重要性、認為將「銳利」和「細節」畫上等號是不正確的、即使柔焦仍可藉由高畫素留住細節…等意見。

這是一位資深電影攝影師的論點,不代表杰客森林的立場,也不論你認同與否,趁這個機會瞭解一下感光元件的學問,其實也是值得的。

Geoff Boyle專訪影片

資訊來源:Rocket Stock